長短期記憶人工神經網路

長短期記憶人工神經網路

長短期記憶人工神經網路是一種時間遞歸神經網路,是為了解決長期以來問題而專門設計出來的,所有的RNN都具有一種重複神經網路模塊的鏈式形式。在標準RNN中,這個重複的結構模塊只有一個非常簡單的結構,例如一個tanh層。

短憶網路(Long-Short Term Memory,LSTM)論文首次發表於1997年。由於獨特的設計結構,LSTM適合於處理和預測時間序列中間隔和延遲非常長的重要事件。

遞歸網路及隱馬爾科夫模型(HMM)更好,比如用在不分段連續手寫識別上。2009年,用LSTM構建的人工神經網路模型贏得過ICDAR手寫識別比賽冠軍。LSTM還普遍用於自主語音識別,2013年運用TIMIT自然演講資料庫達成17.7%錯誤率的紀錄。作為非線性模型,LSTM可作為複雜的非線性單元用於構造更大型深度神經網路。

含區塊()類網路,獻資料區塊描述智網路單元,憶值,區塊夠決否及輸。

右圖底下是四個S函數單元,最左邊函數依情況可能成為區塊的input,右邊三個會經過gate決定input是否能傳入區塊,左邊第二個為input gate,如果這裡產出近似於零,將把這裡的值擋住,不會進到下一層。左邊第三個是forget gate,當這產生值近似於零,將把區塊里記住的值忘掉。第四個也就是最右邊的input為output gate,他可以決定在區塊記憶中的input是否能輸出。

LSTM模型

為了最小化訓練誤差,梯度下降法(Gradient descent)如:應用時序性倒傳遞演演算法,可用來依據錯誤修改每次的權重。梯度下降法在遞迴神經網路(RNN)中主要的問題初次在1991年發現,就是誤差梯度隨著事件間的時間長度成指數般的消失。當設置了LSTM 區塊時,誤差也隨著倒回計算,從output影響回input階段的每一個gate,直到這個數值被過濾掉。因此正常的倒傳遞類神經是一個有效訓練LSTM區塊記住長時間數值的方法。

以下代碼展示了在tensorflow中實現使用LSTM結構的循環神經網路的前向傳播過程。

LSTM網路的變體:雙向循環神經網路和深層循環神經網路

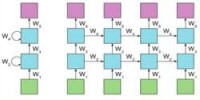

雙向循環神經網路的主體結構是由兩個單向循環神經網路組成的。在每一個時刻t,輸入會同時提供給這兩個方向相反的循環神經網路,而輸出則是由這兩個單向循環神經網路共同決定。其結構如下圖一所示:

圖一

深層循環神經網路:為了增強模型的表達能力,該網路在每一個時刻上將循環體結構複製多次,每一層的循環體中參數是一致的,而不同層中的參數可以不同。其結構如下圖二所示:

圖二