回歸模型

回歸模型

回歸模型(regression model)對統計關係進行定量描述的一種數學模型。如多元線性回歸的數學模型可以表示為y=β0+β1*x+εi,式中,β0,β1,…,βp是p+1個待估計的參數,εi是相互獨立且服從同一正態分佈N(0,σ2)的隨機變數,y是隨機變數;x可以是隨機變數,也可以是非隨機變數,βi稱為回歸係數,表徵自變數對因變數影響的程度。

回歸模型重要的基礎或者方法就是回歸分析,回歸分析是研究一個變數(被解釋變數)關於另一個(些)變數(解釋變數)的具體依賴關係的計算方法和理論,是建模和分析數據的重要工具。在這裡,我們使用曲線/線來擬合這些數據點,在這種方式下,從曲線或線到數據點的距離差異最小。下面是回歸分析的幾種常用方法:

1.Linear Regression線性回歸

它是最為人熟知的建模技術之一。線性回歸通常是人們在學習預測模型時首選的技術之一。在這種技術中,因變數是連續的,自變數可以是連續的也可以是離散的,回歸線的性質是線性的。

線性回歸使用最佳的擬合直線(也就是回歸線)在因變數(Y)和一個或多個自變數(X)之間建立一種關係。

用一個方程式來表示它,即

其中a表示截距,b表示直線的斜率,e是誤差項。這個方程可以根據給定的預測變數(s)來預測目標變數的值。

2.Logistic Regression邏輯回歸

邏輯回歸是用來計算“事件=Success”和“事件=Failure”的概率。當因變數的類型屬於二元(1 / 0,真/假,是/否)變數時,我們就應該使用邏輯回歸。這裡,Y的值從0到1,它可以用下方程表示。

上述式子中,p表述具有某個特徵的概率。

3.Polynomial Regression多項式回歸

對於一個回歸方程,如果自變數的指數大於1,那麼它就是多項式回歸方程。如下方程所示:

在這種回歸技術中,最佳擬合線不是直線。而是一個用於擬合數據點的曲線。

4.Stepwise Regression逐步回歸

在處理多個自變數時,我們可以使用這種形式的回歸。在這種技術中,自變數的選擇是在一個自動的過程中完成的,其中包括非人為操作。

這一壯舉是通過觀察統計的值,如R-square,t-stats和AIC指標,來識別重要的變數。逐步回歸通過同時添加/刪除基於指定標準的協變數來擬合模型。下面列出了一些最常用的逐步回歸方法:

● 標準逐步回歸法做兩件事情。即增加和刪除每個步驟所需的預測。

● 向前選擇法從模型中最顯著的預測開始,然後為每一步添加變數。

● 向後剔除法與模型的所有預測同時開始,然後在每一步消除最小顯著性的變數。

這種建模技術的目的是使用最少的預測變數數來最大化預測能力。這也是處理高維數據集的方法之一。

5.Ridge Regression嶺回歸

嶺回歸分析是一種用於存在多重共線性(自變數高度相關)數據的技術。在多重共線性情況下,儘管最小二乘法(OLS)對每個變數很公平,但它們的差異很大,使得觀測值偏移並遠離真實值。嶺回歸通過給回歸估計上增加一個偏差度,來降低標準誤差。

6.Lasso Regression套索回歸

它類似於嶺回歸,Lasso(Least Absolute Shrinkage and Selection Operator)也會懲罰回歸係數的絕對值大小。此外,它能夠減少變化程度並提高線性回歸模型的精度。看看下面的公式:

7.ElasticNet回歸

ElasticNet是Lasso和Ridge回歸技術的混合體。它使用L1來訓練並且L2優先作為正則化矩陣。當有多個相關的特徵時,ElasticNet是很有用的。Lasso會隨機挑選他們其中的一個,而ElasticNet則會選擇兩個。

Lasso和Ridge之間的實際的優點是,它允許ElasticNet繼承循環狀態下Ridge的一些穩定性。

設因變數為y,k個自變數分別為,x1,x2,…,xk和誤差項ε的方程稱為多元回歸模型。其一般形式可表示為:y=+。式中,是模型的參數;ε為誤差項。

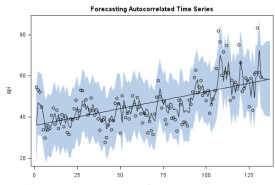

回歸模型是一種預測性的建模技術,它研究的是因變數(目標)和自變數(預測器)之間的關係。這種技術通常用於預測分析,時間序列模型以及發現變數之間的因果關係。例如,司機的魯莽駕駛與道路交通事故數量之間的關係,最好的研究方法就是回歸。

使用回歸分析的好處良多。具體如下:

● ● 它表明自變數和因變數之間的顯著關係;

● ● 它表明多個自變數對一個因變數的影響強度。

回歸分析也允許我們去比較那些衡量不同尺度的變數之間的相互影響,如價格變動與促銷活動數量之間聯繫。這些有利於幫助市場研究人員,數據分析人員以及數據科學家排除並估計出一組最佳的變數,用來構建預測模型。